AKTE-AI-250812-829: Product Manager werden zu Prompt-Architekten, während ihre 128k Token Mega-Prompts die KI-Effizienz zerstören – ein gefährlicher Trend, der Schweizer KMUs überfordert.

Der gefährliche Aufstieg der Mega-Prompts

Die Zahlen sprechen eine deutliche Sprache: Von bescheidenen 4.000 Tokens im Jahr 2018 auf heute 128.000 Tokens – die Kontextlänge von GPT-Modellen hat sich in nur sieben Jahren um das 32-fache vergrössert. Was als technischer Fortschritt gefeiert wird, entwickelt sich zunehmend zu einem zweischneidigen Schwert.

Je mehr Kontext wir den Modellen geben können, desto weniger verstehen wir, was wir eigentlich tun.

Diese Entwicklung hat eine neue Klasse von KI-Nutzern hervorgebracht: Product Manager, die sich als Prompt-Architekten verstehen. Spezialisierte Mega-Prompt-Sammlungen für Product Manager mit über 100 vorgefertigten Prompts erzielen bereits über 190 Verkäufe – ein klares Signal, dass hier ein neuer Markt entsteht.

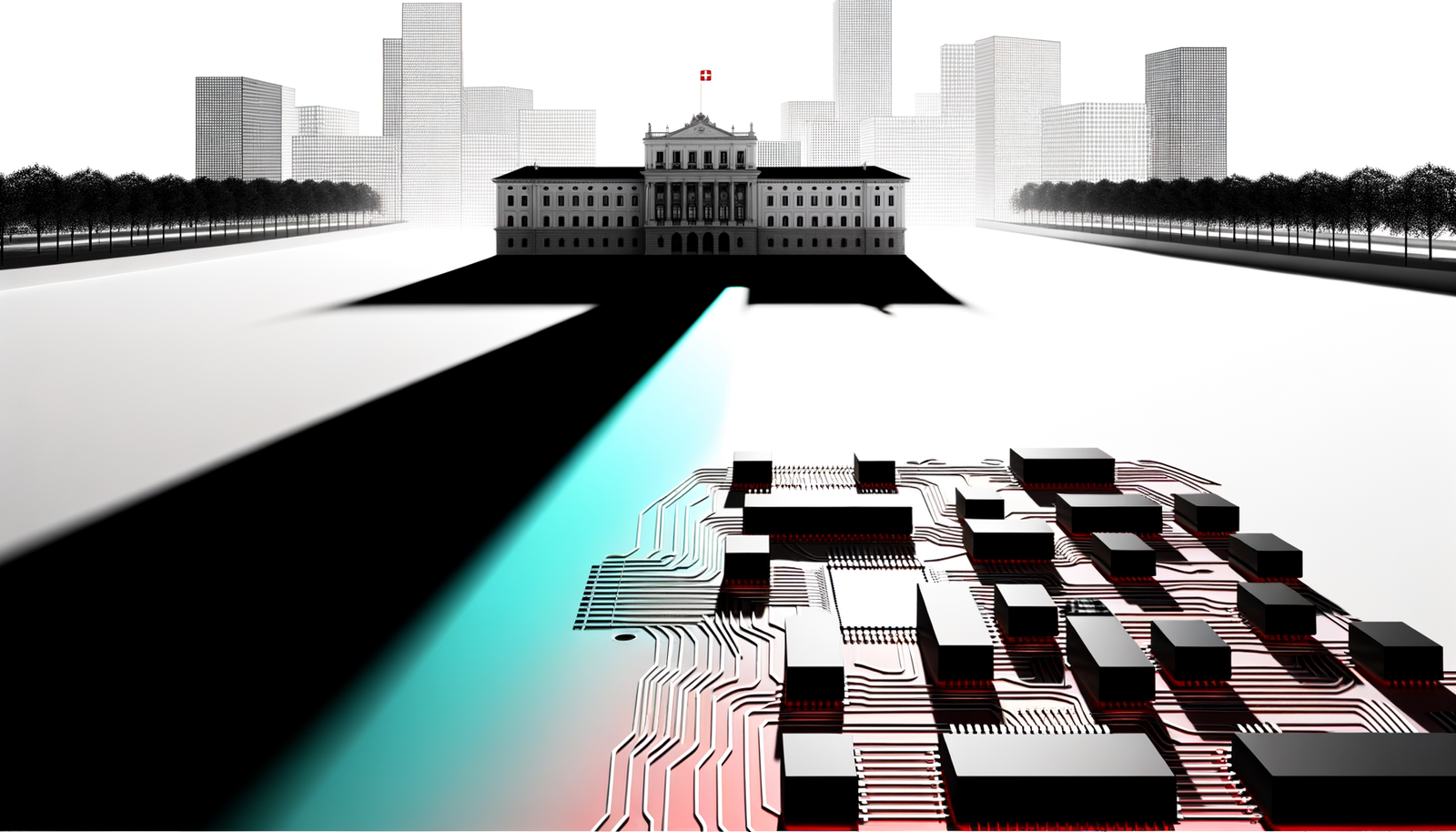

Die Schweizer Perspektive: David gegen Goliath

Für Schweizer Unternehmen stellt diese Entwicklung eine besondere Herausforderung dar. Während internationale Tech-Giganten ganze Teams für die Entwicklung und Wartung von Mega-Prompt-Bibliotheken abstellen, kämpfen hiesige KMUs mit grundlegenden Fragen:

- Wie viel Kontext ist zu viel Kontext?

- Wer ist verantwortlich für die Prompt-Architektur?

- Welche Sicherheitsrisiken entstehen durch komplexe Prompts?

- Wie bleibt man konkurrenzfähig ohne massive Ressourcen?

Die versteckten Kosten der Token-Inflation

Aktuelle Analysen zeigen, dass die scheinbar unbegrenzten Möglichkeiten der 128k Token-Grenze mit erheblichen Nachteilen erkauft werden:

1. Exponentiell steigende Sicherheitsrisiken

Die HackAPrompt-Plattform, weltweit führend im AI Red-Teaming, hat über 600.000 Prompts analysiert. Das Ergebnis ist alarmierend: Mit steigender Prompt-Komplexität wächst das Risiko von Prompt Injection und Jailbreaks exponentiell. Jeder zusätzliche Kontext-Layer bietet neue Angriffsflächen.

2. Die Illusion der Kontrolle

Product Manager, die sich auf vorgefertigte Mega-Prompts verlassen, verstehen oft nicht die zugrundeliegenden Mechanismen. Sie werden zu Anwendern von Black-Box-Systemen, deren Verhalten sie weder vorhersagen noch kontrollieren können.

3. Ressourcenverschwendung im grossen Stil

Jeder Token kostet Rechenleistung und damit Geld. Ein 50.000 Token Prompt, der dasselbe Ergebnis wie ein optimierter 500 Token Prompt liefert, verschwendet das 100-fache an Ressourcen. Bei tausenden von Anfragen summiert sich dies zu erheblichen Mehrkosten.

Context Engineering: Die unterschätzte Alternative

Moderne Ansätze zeigen, dass effektives Prompting nicht von der Menge, sondern von der Qualität des Kontexts abhängt. Context Engineering – die gezielte Optimierung und Strukturierung von Prompts – ersetzt zunehmend das statische Mega-Prompting.

Die Prinzipien erfolgreichen Context Engineerings

- Präzision vor Volumen: Ein gut strukturierter 1.000 Token Prompt übertrifft oft einen unstrukturierten 10.000 Token Prompt

- Dynamische Anpassung: Kontexte sollten sich an die spezifische Aufgabe anpassen, nicht umgekehrt

- Self-Criticism Integration: Automatisierte Prompt-Optimierung durch Selbstkritik-Mechanismen verbessert mehrstufige Reasoning-Aufgaben signifikant

- Conversational Archetypes: Die besten Prompts simulieren natürliche Gesprächsmuster statt technischer Anweisungslisten

Product Manager als Prompt-Architekten: Fluch oder Segen?

Die Verschiebung der Verantwortung für KI-Interaktionen von technischen Teams zu Product Managern markiert einen fundamentalen Wandel in der Organisationsstruktur. Diese Entwicklung birgt sowohl Chancen als auch erhebliche Risiken.

Die Vorteile

Product Manager bringen einzigartige Stärken in die Prompt-Entwicklung ein:

- Tiefes Verständnis der Nutzeranforderungen

- Fähigkeit zur Übersetzung zwischen Business und Technik

- Fokus auf messbare Ergebnisse

- Iterative Optimierungsansätze

Die Gefahren

Gleichzeitig entstehen neue Herausforderungen:

- Fehlendes technisches Tiefenverständnis der KI-Modelle

- Tendenz zur Überoptimierung ohne Verständnis der Grundlagen

- Vernachlässigung von Sicherheitsaspekten

- Entstehung von Wissenssilos zwischen Teams

Die Schweizer KI-Strategie: Qualität statt Quantität

Für Schweizer Unternehmen ergibt sich aus dieser Analyse eine klare Handlungsempfehlung: Statt dem internationalen Trend der Mega-Prompts blind zu folgen, sollten sie auf ihre traditionellen Stärken setzen – Präzision, Qualität und Effizienz.

Konkrete Handlungsempfehlungen für Schweizer KMUs

1. Investition in Ausbildung statt Prompt-Bibliotheken

Anstatt teure Mega-Prompt-Sammlungen zu kaufen, sollten Unternehmen in die Ausbildung ihrer Mitarbeitenden investieren. Ein fundiertes Verständnis der KI-Grundlagen ist nachhaltiger als jede vorgefertigte Prompt-Sammlung.

2. Entwicklung eigener Context-Engineering-Standards

Schweizer Unternehmen sollten eigene Standards für effizientes Context Engineering entwickeln, die auf ihre spezifischen Bedürfnisse zugeschnitten sind. Diese Standards sollten:

- Maximale Token-Grenzen für verschiedene Anwendungsfälle definieren

- Sicherheitsrichtlinien für komplexe Prompts etablieren

- Messbare Effizienzkriterien festlegen

- Regelmässige Überprüfungen vorsehen

3. Interdisziplinäre Teams statt isolierte Prompt-Architekten

Statt Product Manager zu alleinigen Prompt-Architekten zu machen, sollten interdisziplinäre Teams gebildet werden, die:

- Business-Expertise (Product Manager)

- Technisches Know-how (Engineers)

- Sicherheitskompetenz (Security Specialists)

- Ethische Überlegungen (Compliance)

vereinen.

Die Zukunft des Promptings: Weniger ist mehr

Die aktuelle Entwicklung zeigt deutlich: Die Zukunft gehört nicht den längsten, sondern den klügsten Prompts. Automatisierte Optimierungsmechanismen, wie sie bereits in fortgeschrittenen Systemen zum Einsatz kommen, werden zunehmend die rohe Token-Menge als Qualitätsmerkmal ablösen.

Emerging Trends im Context Engineering

- Adaptive Prompting: Systeme, die ihre Prompts basierend auf vorherigen Interaktionen automatisch anpassen

- Multi-Stage Reasoning: Komplexe Aufgaben werden in mehrere, präzise formulierte Teilschritte zerlegt

- Security-First Design: Sicherheitsaspekte werden von Anfang an in die Prompt-Architektur integriert

- Performance Monitoring: Kontinuierliche Überwachung und Optimierung der Prompt-Effizienz

Der Weg nach vorn: Pragmatismus statt Perfektionismus

Die Schweizer KI-Landschaft steht an einem Scheideweg. Die Verlockung, dem internationalen Trend zu folgen und in immer komplexere Prompt-Systeme zu investieren, ist gross. Doch die Analyse zeigt: Dieser Weg führt in eine Sackgasse aus steigenden Kosten, wachsenden Sicherheitsrisiken und abnehmender Kontrolle.

Stattdessen sollten Schweizer Unternehmen auf ihre Stärken setzen:

- Präzision statt Volumen

- Verständnis statt blinde Anwendung

- Sicherheit statt Geschwindigkeit

- Nachhaltigkeit statt kurzfristige Gewinne

Die neue Rolle der Product Manager

Product Manager müssen nicht zu technischen Experten werden, aber sie müssen die Grenzen und Möglichkeiten der Technologie verstehen. Ihre Rolle sollte sich auf die strategische Ausrichtung und die Definition von Anforderungen konzentrieren, während die technische Umsetzung in enger Zusammenarbeit mit spezialisierten Teams erfolgt.

Fazit: Die Mega-Prompt-Blase wird platzen

Die aktuelle Begeisterung für 128k Token Mega-Prompts erinnert an frühere Technologie-Hypes: Anfängliche Euphorie, gefolgt von der schmerzhaften Erkenntnis, dass mehr nicht automatisch besser bedeutet. Die Unternehmen, die jetzt in nachhaltiges Context Engineering und fundierte Ausbildung investieren, werden langfristig die Gewinner sein.

Für die Schweizer KI-Landschaft bedeutet dies eine Chance: Während internationale Konkurrenten Ressourcen in immer komplexere Prompt-Systeme stecken, können hiesige Unternehmen durch Fokussierung auf Effizienz und Qualität einen entscheidenden Wettbewerbsvorteil erlangen.

Die Zukunft gehört nicht den längsten Prompts, sondern den Unternehmen, die verstehen, dass wahre KI-Kompetenz in der Fähigkeit liegt, mit minimalem Input maximale Ergebnisse zu erzielen.